Na první pohled by se mohlo zdát, že umělá inteligence je především o tvoření komplikovaných algoritmů. Bez statistiky a pravděpodobnosti by však AI nikdy nemohla fungovat.

Důvod, proč je pravděpodobnost pro počítače důležitá, si můžeme ukázat na rozdílu ve zpracovávání informací mezi lidmi a počítači. Existuje tu totiž zásadní rozdíl s nakládáním s nejistotou.

Lidský mozek se vyvinul k přežití v nehostinném prostředí, kde neexistovala žádná jistota, o níž by se pradávný člověk mohl opřít. Lidský mozek mohl operovat pouze s pravděpodobností a s ničím jiným, protože jistota je v nehostinném světě absurdní, jak ostatně praví slavný bonmot Voltaira. Zjednodušeně řečeno, v džungli cílem nebylo vypočítat pokaždé stejně přesný výsledek, cílem bylo nenechat se sežrat. I díky tomu lidé mají schopnost se přizpůsobit novým situacím a reagovat na ně s kreativitou.

Počítače na rozdíl od lidí pracují precizně. Když se programu zadá požadavek, můžeme se spolehnout, že ho splní vždy stejně. Počítače ve výpočtech efektivní díky tomu, že pracují v přehledném prostředí, kde je vše na 100 % určeno algoritmem předem naprogramovaným lidmi. U jednoduchých programů tak něco jako nejistota neexistuje, operují v předvídatelném prostředí.

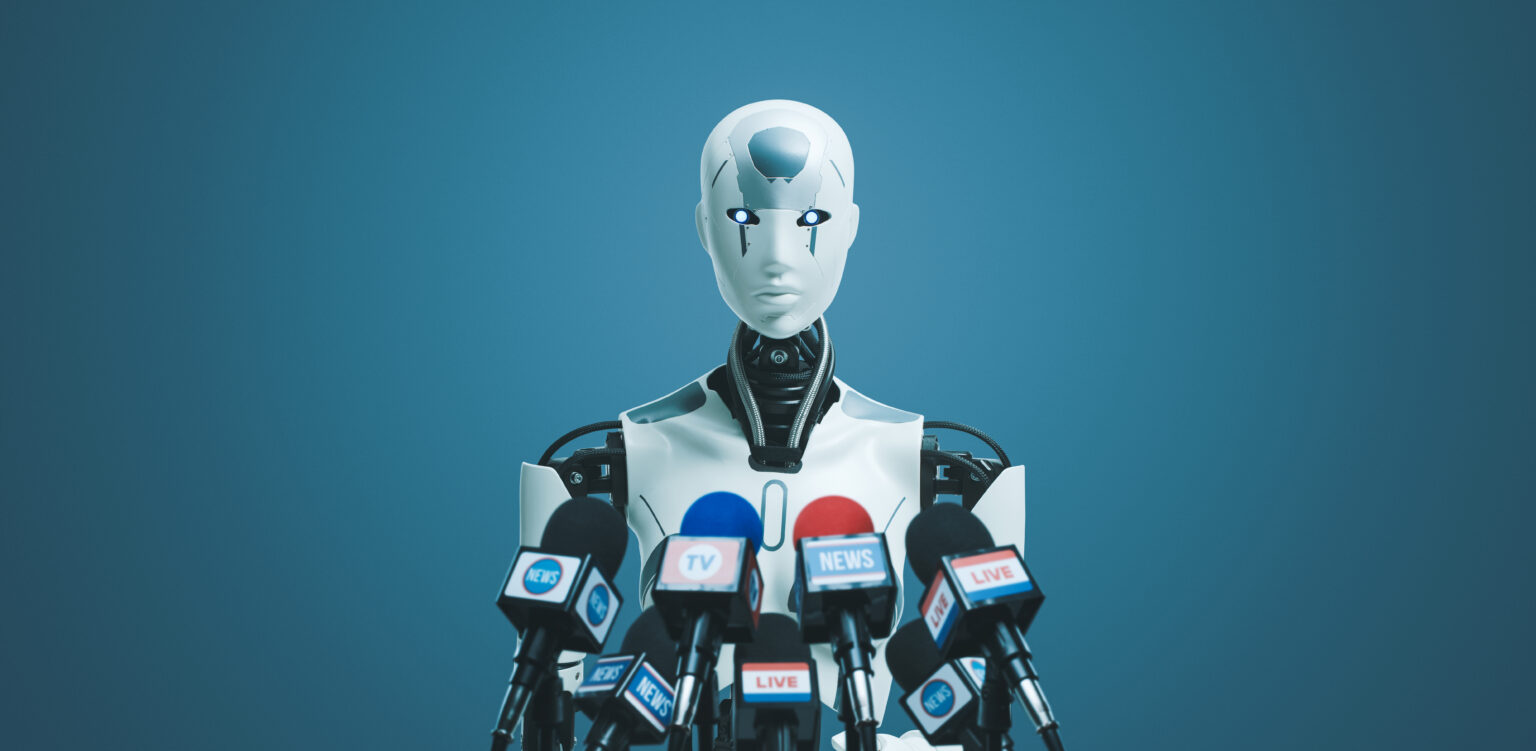

Dalo by se říci, že počítačové programy byly vytvářeny s cílem počítat předvídatelné výsledky. Schopnost předvídat nepředvídatelné, tedy vlastnost, jíž si musel lidský mozek osvojit k přežití, bylo něco, co počítače dlouho neměly. Ani nikdy tuto schopnost nepotřebovaly. Spočítat velké objemy víceméně jednoznačných dat, řadit maily na základě jednoduchého spamového filtru – to jsou všechno úkoly, v nichž máme perfektní informace o celém systému (bez žádné nejistoty), a v nich počítače tudíž excelují. Bohužel, ve skutečném světě jsou věci jen zřídkakdy tak jasné. „Namísto přesných informací existuje řada neznámých možností od chybějících informací až po záměrné klamání,“ upozorňuje Elements of AI. Jako příklad ukazuje Elements of AI samořídící auto. Můžeme mu sice stanovit cíl, aby se dostalo z bodu A do bodu B účinným a bezpečným způsobem, který bude dodržovat všechny zákony. Ale co se stane, když se provoz zhorší, než se očekávalo, možná kvůli nehodě před námi? Nebo náhodné události, jako je míč poskakující na ulici nebo kus odpadu, který letí přímo do kamery auta?

Normální program by se v případě sebemenší odchylky zadrhl. Znáte to, dvě hodiny pracujete na funkcích excelové tabulky nebo programu a na konci vám počítač “vyplivne” zprávu, že se vyskytl problém v syntaxi a někde v kódu jste museli nepřesně zapsat instrukci. Ale samořídící auto se kvůli vstupu neznámé proměnné zadrhnout nemůže, protože situaci musí vyhodnotit hned a jestli jí nevyhodnotí, budou následovat reálné důsledky.

Jak tedy počítače přimět, aby pracovaly i s nedostatečným množstvím informací, tj. ne za dokonalých podmínek? Na scénu vstupuje pravděpodobnost. Díky ní můžeme mluvit o nejistotě (a rizicích) jako o věci, kterou lze alespoň v principu kvantifikovat. Můžeme díky tomu zjistit, jaká je šance, že auto nabourá, když překročí povolenou rychlost nebo jaká je šance, že se sazba hypotéky v následujících pěti letech zvýší. Pravděpodobnost zároveň promlouvá i u samotného jádra komplexních systémů jako je ChatGPT, který ve své podstatě “pouze” předpovídá, jaké další slovo by mělo následovat ve větě.

Právě důležitost tréninku při určování pravděpodobnosti Elements of AI zdůrazňuje: k vyvození závěrů o fenoménech, jež se na začátku jeví jako obtížně předvídatelné, obvykle potřebujeme mnoho pozorování. Systematickým shromažďováním dat však můžeme z původně chaotického systému vyvozovat vzorce a závěry, na jejichž základě je možné výsledky vyhodnotit jako správné nebo nesprávné.

Není náhoda, že tím se počítače blíží lidskému vnímání světa, které je postavené na neustálých korekcích na základě interakcí se světem, tedy na základě “tréninku” v nepřeberném množství dat. Ostatně, jeden z nejvýznamnějších algoritmů používaných v oboru AI, se nazývá “neurální sítě”, které byly vytvořeny na základě pozorování lidských neuronů.